本文最后更新于182 天前,其中的信息可能已经过时,如有错误请发送邮件到939925357@qq.com

Graph CoT [提示工程]

前言:

博主摆烂一年多了,主要是日常各种大作业太忙了,一直没时间整理好笔记发博客,但实际上博客草稿其实已经攒了一大堆了。现在好不容易闲下来了,该好好沉淀沉淀了,这里立一个flag,至少保持一周一更qwq。

论文来源:Graph Chain-of-Thought: Augmenting Large Language Models by Reasoning on Graphs

对应开源代码库: https://github.com/PeterGriffinJin/Graph-CoT

主要贡献:

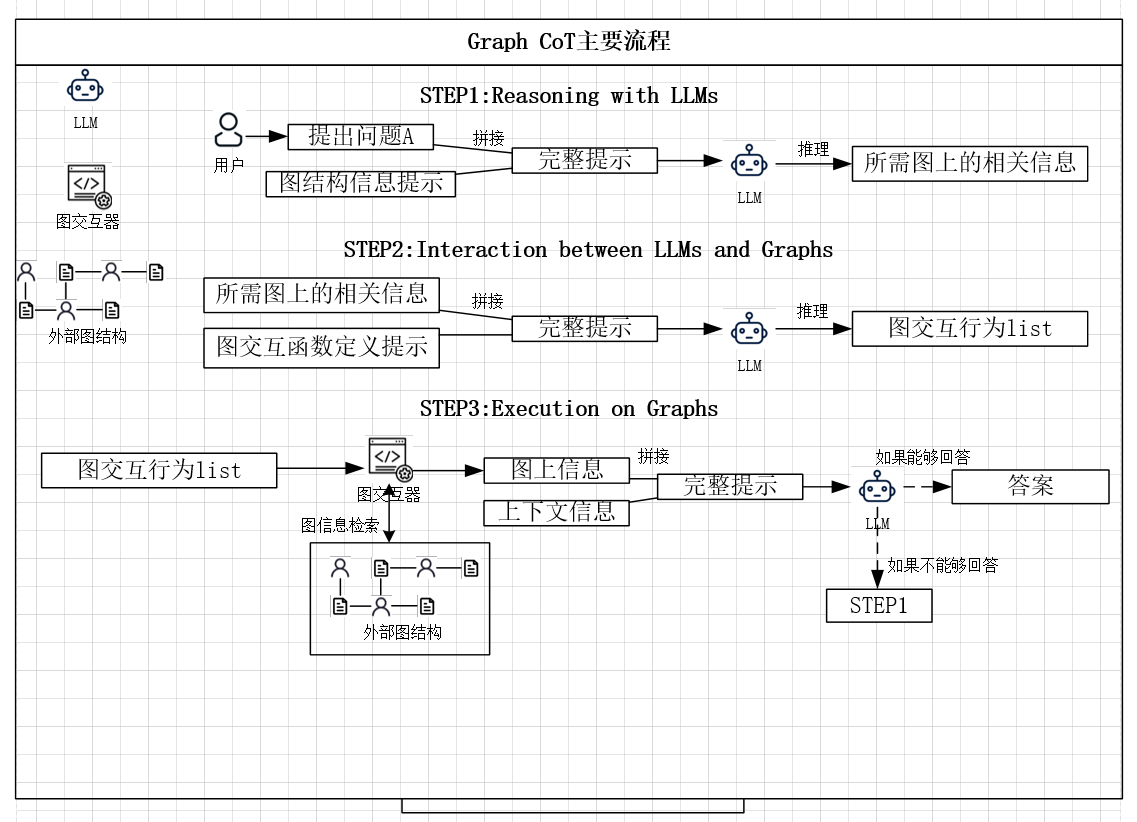

创造了一种新的图结构数据集,同时提出了一种类似于agent的框架,同样是并没有修改大模型本身结构,创新点在提示工程+外部图数据检索方式上。

本文提出的Graph CoT主要包含3个主要步骤:

1.Reasoning with LLMs

2.Interaction between LLMs and Graphs

3.Execution on Graphs

示意图:

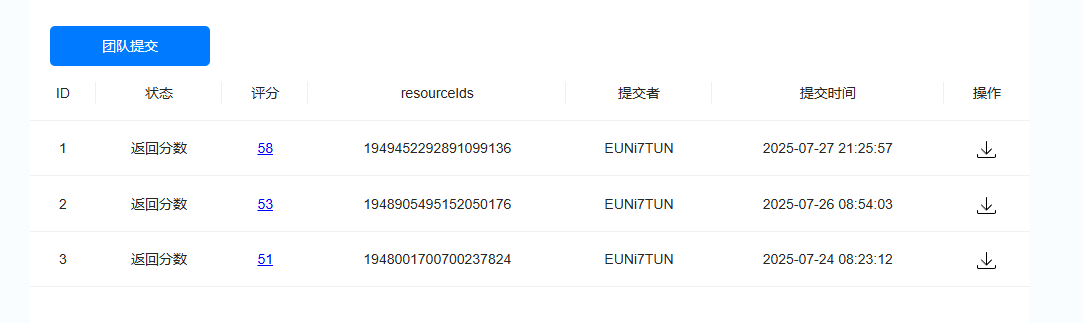

实验结果

作者实验发现上图作为基础的LLM如果它的instruction following ability和reasoning ability越强,最后效果也越好。

同时作者还将该方法和常见的Text RAG 和Graph RAG进行了比较,结果显示:

Graph CoT > Graph RAG > Text RAG

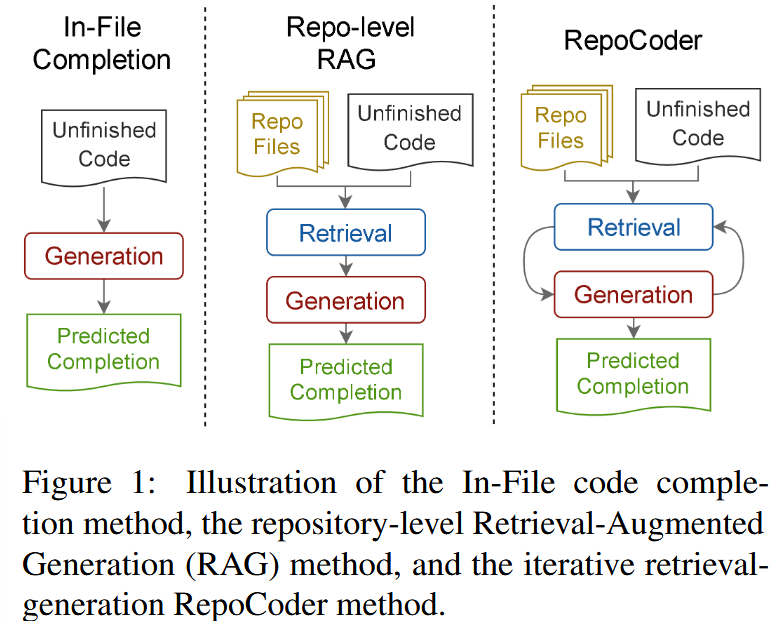

这里有必要去补一下相关RAG的论文: